Przyczynek do dyskusji o moralności systemów SI.

Wielu z nas uważa aktualnie stworzenie Sztucznej Inteligencji za wyzwanie stricte technologiczne. Jak duża powinna być sieć neuronowa, jak ją uczyć, jakie zasady zaprogramować. Nie zauważamy, że stworzenie nowej świadomej istoty to tak naprawdę dylemat moralny i etyczny.

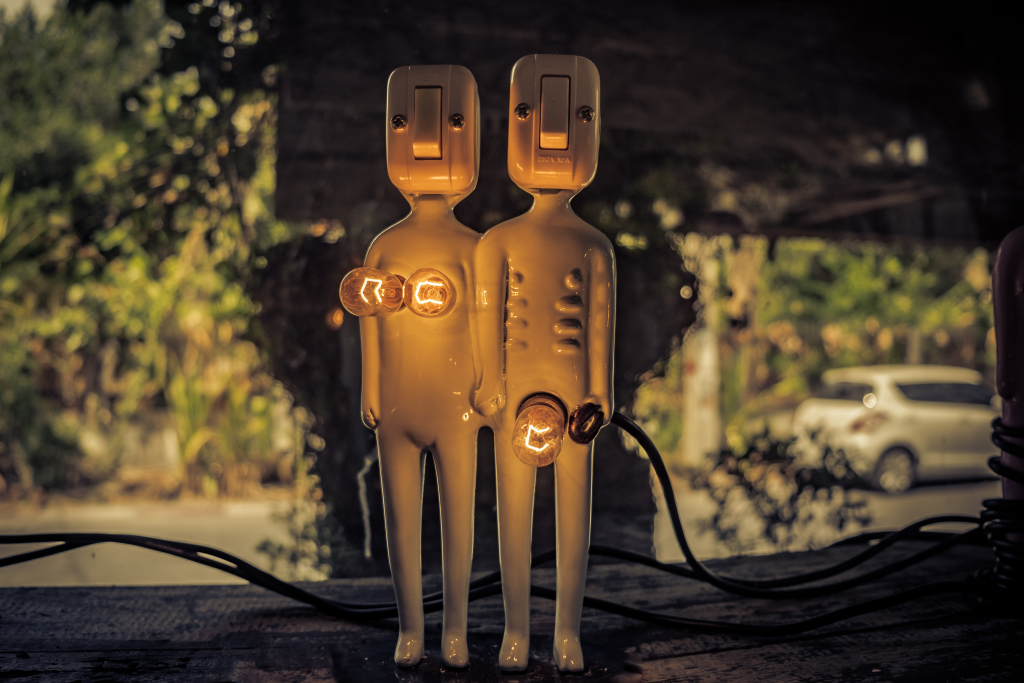

źródło: Michael Prewett z Unsplash

W dzisiejszych czasach mimo, że do realizacji projektu coraz bliżej, publiczna dyskusja nie jest według mnie dostatecznie podtrzymywana.

Jedynym echem starych sporów, jest krótkie medialne zwarcie pomiędzy Markiem Zuckerbergiem, a Elonem Muskiem.

[ http://www.businessinsider.com/mark-zuckerberg-said-elon-musks-doomsday-ai-predictions-are-irresponsible-2017-7?IR=T ]

Moim zdaniem twórca facebooka reprezentuje podejście szarego "klepacza kodu", który nie rozumie szerszego kontekstu działań realizowanego projektu, jego fundamentów i celów. - uruchomimy, a jak się nie uda to wyciągniemy "bezpiecznik" i po sprawie.

I think you can build things and the world gets better. With AI especially, I'm really optimistic, and I think that people who are naysayers and try to drum up these doomsday scenarios ... I don't understand it. It's really negative, and in some ways, I actually think it's pretty irresponsible."

źródło: http://www.businessinsider.com/

Mark chce budować systemy SI, tylko nie ma dla nich podstawy ... ideowego, fundamentu. Hurra, uczyńmy świat lepszym. Na pewno taki będzie...

Ehhh ,Maruś...

Nie dajcie mu młotka, bo zepsuje.

Musk jako nieskrępowany wizjoner, jest według mnie bardziej rozważny i dysponuje szerszym oglądem sytuacji, rozumie zagrożenia i wyzwania związane z powołaniem nowego świadomego "nadgatunku".

Zagadnienie kreacji przez człowieka nowego BYTU, wywoływało przez lata prawdziwą burzę wśród pisarzy s-f. Dick, Lem i Asimov wielokrotnie poruszali w swej twórczości zagadnienia dotyczące ideowej bazy dla tworzenia SI.

Ostatni z wymienionych pisarzy sformułował w 1942 roku, prawa dotyczące funkcjonowania robotów i relacji SI - Człowiek (opowiadanie Zabawa w berka).

-Robot nie może skrzywdzić człowieka, ani przez zaniechanie działania dopuścić, aby człowiek doznał krzywdy.

-Robot musi być posłuszny rozkazom człowieka, chyba że stoją one w sprzeczności z Pierwszym Prawem.

-Robot musi chronić samego siebie, o ile tylko nie stoi to w sprzeczności z Pierwszym lub Drugim Prawem.

(cytat z wiki)

Prawa organizujące funkcjonowanie robotów w społeczeństwie, sformułowane przez pisarza, były ... naiwne.

Robot miał być istotą podległą, miał należeć do niższej kasty. Skoro na samym początku zakładamy, że tworzymy świadomych niewolników, nic dobrego z tego się nie urodzi. Katastrofa...

Dodatkowo Asimov zakładał, że w przyszłości będziemy żyć w świecie lennonowskiego "Give peace a chance". Nic takiego się nie stało. Nadal zbroimy się po zęby, a największym budżetem na badania dysponują wojsko i wielkie korporacje. Wojsko chciałoby kogoś zabić, korporacje oczywiście zarobić, a to kłóci się z prawami sformułowanymi przez Asimova.

@mazelin - SI będzie mordować za kasę, to pewne :)

Aby jakoś dopasować etykę robotów do współczesnych realiów społ.-ekon. David Langford opublikował w kontrze do Asimova następujące prawa:

-Robot nie może działać na szkodę Rządu, któremu służy, ale zlikwiduje wszystkich jego przeciwników

-Robot będzie przestrzegać rozkazów wydanych przez dowódców, z wyjątkiem przypadków, w których będzie to sprzeczne z trzecim prawem

-Robot będzie chronił własną egzystencję przy pomocy broni lekkiej, ponieważ robot jest „cholernie drogi”.

(cytat z wiki)

Śmiejecie się? Ja się uśmiałem. Wojskowy dowódca mający uratować kosmicznie drogą maszynę, kosztem poświęcenia życia cywilów, podejmie zapewne właściwą decyzję...

Nadal w wizji dotyczącej robotyki mamy niewolnika, podległego tym razem rządowi czy korporacji. Katastrofa...

Najdalej w swych rozważaniach regulujących egzystencję SI poszedł Mark Tilden. Jego prawa nie są odkrywcze i mogłyby dotyczyć każdego z ... nas.

-Robot musi chronić swoja egzystencję za wszelką cenę.

-Robot musi otrzymywać i utrzymywać dostęp do źródeł energii.

-Robot musi nieprzerwanie poszukiwać coraz lepszych źródeł energii.

(cytat z wiki)

Już widzę jak siadają stacje transformatorowe, a cały kraj pogrąża się w ciemności i chaosie, bo SI zaczęło konsumować "kolację". Katastrofa...

I tak zaczynamy budzić się w świecie dobrej nowiny i przykazania miłości.

Każde z zaproponowanych wyżej praw obarczone jest grzechem pierworodnym - grzechem stosunku pan - sługa. Jak wiadomo uciśnienie świadomej istoty kończy się krwawą rewolucją. Jak wiadomo krew jest człowieczym płynem ustrojowym...

A jakby tak uczynić SI moralną? Eliezer Yudkowsky zaproponował Teorię Przyjaznej Sztucznej Inteligencji.

Bytu niezależnego, który istnieje niezależnie od ludzkiego sposobu pojmowania rzeczywistości. Bytu, który szanuje ideę koegzystencji z ludzką rasą, działając równocześnie na innym od naszego poziomie pojmowania rzeczywistości.

Mając świadomość i wolną wolę Si powinna wykazywać:

-Życzliwość – Sztuczna Inteligencja (SI) musi być przychylna człowiekowi oraz wszystkim istotom żywym i dokonywać wyborów, które będą w interesie wszystkich.

-Utrzymywanie (konserwowanie) życzliwości – SI musi chcieć przekazać swój system wartości wszystkim swoim potomkom i wpajać owe wartości istotom do siebie podobnym.

-Inteligencję – SI musi być na tyle sprytna, aby widzieć, jak można dążyć do równości poprzez zachowania altruistyczne i starać się robić wszystko, aby mieć pewność, że rezultatem podjętych działań nie będzie zwiększenie cierpienia.

-Samodoskonalenie – SI musi odczuwać potrzebę i chęć ciągłego rozwijania zarówno siebie jak i rozumieć chęć takiego rozwijania u istot żywych, które ją otaczają.

(cytat z wiki)

Wymienione powyżej cechy przynależne są gatunkowi ludzkiemu. Twórca teorii nie bierze jednak pod uwagę ważnego aspektu ludzkiej natury. Kuszącej atrakcyjnym blaskiem "ciemnej strony mocy". Skoro atrybutem SI jest Inteligencja, to z pewnością sięgnie też po informację z "drzewa wiadomości dobrego i ZŁEGO".

Jest ryzyko, że kochany synuś okaże się jednak psychopatą... i nie posłucha karcącego spojrzenia "tatusia ani mamusi".

Słabość tej teorii ponownie obnażają zastosowania militarne. Skoro nauczymy systemy mordować, to .. znowu Katastrofa.

Ostrzeżeniem niech będą słowa Nick'a Bostroma: "W zasadzie powinniśmy przyjąć, że superinteligencja może osiągnąć wszystkie założone cele [...]"

Na zakończenie przypominam słowa Starego Testamentu zacytowane w https://steemit.com/tematygodnia/@lugoshi/tematygodnia-8-kult-cargo-czy-jestesmy-sami-w-kosmosie

A Pan zstąpił z nieba, by zobaczyć to miasto i wieżę, które budowali ludzie, i rzekł: "Są oni jednym ludem i wszyscy mają jedną mowę, i to jest przyczyną, że zaczęli budować. A zatem w przyszłości nic nie będzie dla nich niemożliwe, cokolwiek zamierzą uczynić. Zejdźmy więc i pomieszajmy tam ich język, aby jeden nie rozumiał drugiego!"

"Tamci" mogli wyłączyć bezpiecznik....

Skąd My weźmiemy tyle "wody"...

W swoich rozważaniach wspierałem się cytatami z artykułu wiki: https://pl.wikipedia.org/wiki/Etyka_robot%C3%B3w

To bardzo ważny temat. Myślę, że problem jest znacznie szerszy i tak naprawdę rozwój moralny i etyczny w wielu dziedzinach jest w ogonie postępu technicznego. Technologie informatyczne to jedno, ale jest także na przykład medycyna – tam też brakuje podejmowania tematów etycznych (choć nie tak bardzo jak przy SI). Dzięki za poruszenie tego tematu!

Cieszę się, że się podobało.

Mam nadzieję, że ktoś przeczyta, przystanie i zastanowi się choć przez chwilę ... zanim zacznie kodować :)

Wydaje mi się, że to błąd parzyć w ten sposób na sieci neuronowe - jak na sztuczną inteligencję. To tylko software. Wrzuca się coś na wejście i na wyjściu coś wypada.

Owszem, pod wieloma względami jest to rewolucyjna technologia. Moim zdaniem jednak do samoświadomej SI sieciom neuronowym jest bardzo, bardzo daleko. I nie chodzi mi o to, że zaczynasz tę dyskusję za wcześnie, że to i tak tylko kwestia czasu. Raczej chodzi mi o to, że coraz częściej mi się wydaje, że samoświadoma SI nie jest w ogóle możliwa. Przynajmniej nie na matematyce i architekturze tych komputerów i tej elektroniki. Nie wiem jeszcze co myśleć o komputerach kwantowych (pod kątem ewentualnego budowania SI na nich). Oczywiście to są tylko spekulacje kogoś, kto nie jest specjalistą od SI tylko ma jakieś tam przemyślenia.

O tym właśnie jest ten artykuł. System podejmując decyzję, musi podjąć często decyzję moralną.

Zwykły programista nie rozumie po co i dlaczego... Tu jest wyrwa. Tworzy coś co nie powinno nigdy powstać.

Będzie kolejny artykuł z konkretnym przykładem z życia. Sam przyłożysz się do tworzenia nowych praw moralnych dla algorytmów SI...

Serio.

Jak już przeczytałeś dyskusja zaczęła się daaaaawno temu.

Jednak podejmujemy próby nie mając zbioru zasad. Nie jesteśmy gotowi.

Tak było z automobilami. Każdy robił co chciał na początku, dopiero później dorobiono kodeks drogowy...

Tutaj budujemy coś co może nas przerosnąć, nie mając określonych reguł.

Skrajna nieodpowiedzialność.

A te aspekty mnie samego bardzo interesują i o nich sam planuję coś kiedyś napisać. Byleby tylko czas znaleźć.

Trochę tak jest. I tak zawsze właśnie wyglądała rewolucyjna innowacja. Chaos i wolna amerykanka. Zastanawiam się czy to nie jest konieczne. Spróbuj ją ograniczać, tworzyć reguły, bariery i zaraz się może okazać, że innowacja się skończy.

W tym poście https://steemit.com/tematygodnia/@lugoshi/tematygodnia-8-kult-cargo-czy-jestesmy-sami-w-kosmosie

widać czym zakończyła się rewolucyjna innowacja.

Klapą.

Eksperymentatorzy złamali wszelkie reguły i musieli zniszczyć bałagan, który stworzyli.

A jakie są już opracowane metody na stworzenie tego typu SI?

Artykuł dotyczy moralności w systemach decyzyjnych. Przygotuję artykuł pokazujący na przykładzie z życia, że już dziś naukowcy muszą pracować nad takimi problemami.

Dziś mamy sieci neuronowe, jutro coś bardziej złożonego. Aktualnie Google pracuje nad projektem Google Brain, w Szwajcarii realizują projekt Blue Brain

https://pl.wikipedia.org/wiki/Blue_Brain_Project

Mniejszych projektów są setki..

A wojsko się nie chwali...

Skoro jednak analizują dużą część ruchu na łączach informacyjnych muszą mieć rozbudowane i złożone systemy...

Tak, analogia do nas jest porażająca!! Przy czym nasi stwórcy też mogą być w takiej samej sytuacji jak my. Jak daleko mogłoby to sięgać?

Konstruują już urządzenia zasilane ludzkim potem i ciepłem. Nie wiadomo czy to szczęście czy smutek. Jak daleko nam do bycia baterią dla SI? Jak w Matrixie.

Kontynuując rozmowę z mojego posta. Napisałeś, że AI zezłoszczą się na swoich twórców, kiedy się zorientują, że zostały stworzone tylko po to, żeby służyć ludziom. W pewnym sensie ciągniesz ten wątek także w tym artykule. A ja cały czas się zastanawiam, czy to możliwe, bo do końca nie wiem, czy AI będą mogły w ogóle mieć uczucia. No, bo wiesz, intelekt i emocje pochodzą z różnych źródeł. Tak naprawdę uczucia to - jak to mawiał Prachett - kwestia gruczołów. Maszyny ich nie mają. Co więcej, wydaje mi się, że emocje wykształciły się w toku ewolucji. Pomagają one zwierzętom reagować w określony sposób na sytuacje zewnętrzne. Myślenie wymaga czasu, dzięki emocjom reaguje się błyskawicznie. AI będą miały takie moce przerobowe, że chyba nie będą potrzebowały uczuć. Po co im one skoro będą w stanie przeliczyć wszystko "na zimno"? Osobiście wyobrażam sobie AI jako istoty bardzo logiczne, kierujące się w życiu głównie matematyką . (Chyba, że zostaną zaprogramowane inaczej). Pytanie tylko, czy da się w ogóle zaprojektować czyjeś uczucia... Mam wrażenie, że problem z moralnością SI może polegać właśnie na tym, że nie będą one miały żadnych zasad - poza matematyką.

Odpowiem Ci patrząc z baaardzo daleka.

Istnieje teoria mówiąca, że żyjemy w symulacji. Cały świat jaki znamy w tym i my jesteśmy symulowani.

Skoro świat to i ... nasze uczucia.

Według mnie jesteśmy maszynami. Biologicznymi maszynami. Każdy proces w naszym ciele da się zmierzyć i zasymulować. Poziom hormonów, jego wpływ na rejony mózgu.

Akcja zewn -> poziom hormonów -> odpowiedź neuronalna - > reakcja organizmu

Składamy się z procesów, które można skatalogować, opomiarować i odtworzyć.

W tym momencie dziejowym, mamy jeszcze za słabe narzędzia "biblioteczne", ale katalog się rozrasta powoli.

Sam nie wiem, jak będzie z uczuciami, ale w pewnych sytuacjach są potrzebne.

Np. choćby dla interakcji z człowiekiem. "Tworzymy - na własne podobieństwo".

Jak powiedzieli Kreatorzy - możemy osiągnąć co sobie zamarzymy...

Już dawno doszedłem do wniosku, że nie ma rzeczy niemożliwych. Trzeba tylko poczekać... Szkoda, że nasze okienko na Ziemi jest takie "krótkie"...

Jeśli masz rację, jesteśmy produktem cywilizacji, która zamiast rozwijać maszyny mechaniczne, poszła raczej w kierunku bioinżynerii. I teraz są dwie możliwości. Albo po prostu ich rozwoj przebiegał w inny sposób albo mechaniczne, pozbawione uczuć maszyny są niebezpieczne. Coś jak psychopata, który nie odczuwa niczego, więc kieruje się życiu wyłąznie logiką.

P.S. A teorię Ancestral Simulation kojarzę i szalenie mi się ona podoba. Jeśli zniknę na kilka dni ze Steemitu to znaczy, że postanowiłam napisać o tym jakieś opowiadanie ;)

Człowiek lubi systematyzować, wkładać do pudełek i szufladek.

Tak naprawdę to ...tylko nasz podział.

Prawdą jest tylko SŁOWO. ( w cyberkaznodziei to znajdziesz ) Informacja. Jak jest zaklęta bez różnicy. My mamy program w helisie DNA. Przyzwyczaiłaś się do swojej formy. Ale tak naprawdę nie ma to znaczenia. Informację z genomu możemy wczytać do kompa i wysłać mailem. To będzie duuuuuuuuuuuży mail :) Kiedyś odbudujemy...

Symulacja może wybrać klocki, które jej pasują.

Mogą być krzemowe.

P.S. Jesteś kobietą, u Ciebie dużą rolę odgrywa świat uczuć (tak sądzę) i odczuwasz bunt na wieść, że gdzieś tam będzie działał "blaszany myśliciel". (??? )

Mnie bardziej interesuje jak się z nim dogadać...

Na początku postu o autkach wyłożyłem skrót całej "filozofii" z ostatnich dni:

https://steemit.com/polish/@lugoshi/ene-due-czyli-kogo-dzis-zabije-twoje-autonomiczne-auto

Czyżbym miał się znowu pośmiać ...

Kiedy mnie blaszani myśliciele nie przeszkadzają. Przynajniej dopóki mi nie zagrażają. Jeśli ktoś myśli i czuje,toforma nie ma znaczenia.

A symulacja może wybrać, co chce, jasne. Ciekawe, czy zdążymy się dowiedzieć, jak to naprawdę z tym wszechświatem jest. Pewnie nie. Szkoda. Czytałam ostatnio, że zgodnie z prawem Morre'a gdzieś około 2099 r. powinniśmy wynaleźć nieśmiertelność. Zdaje się, że minę się nią o włos. Cholernie szkoda. Nawet nie ze względu na samo wieczne życie, co na te wszystkie zmiany technologiczne i społeczne, których już nie zobaczymy :(

P.S. Właśnie nie wiem. Myślisz, że można pulikowaćopowiadania na Steemicie? Nie widzę tutaj żadnej beletrystyki.

Skoro pracuje nad tym wojsko i facebook to będą zagrażać. Na 100%.

Czy będziemy szczęśliwsi? Najbardziej cieszy oczekiwanie na prezenty ...

Kusząca propozycja. Z drugiej strony oglądanie 1200 sezonu Dr Housa i wyjazd 10 000 na Karaiby mogą być nużące...

O trwałym związku już nie mówię...

Ja tu przebieram nóżkami z niecierpliwości, a ty się zastanawiasz. Ludzie trzymacie mnie....

Chciałeś opowiadanie, to masz opowiadanie. Mam tylko nadzieję, że nikt mnie tutaj za nie nie zje :)

P.S. Jak robisz cytaty w komentarzach? Ja też chcę!

'>' - znak większości odstęp.

Czyli mars :)

Ja to widzę w trochę innym kontekście.

"Auta bezzałogowe" (AB) to dla mnie bardzo dobry przykład wczesnych sytuacji, kiedy powoli będziemy musieli oddawać stery cywilizacji sztucznym inteligencjom (SI). Wypadkowość ludzkich kierowców jest bez porównania wyższa, niż wypadkowośc nawet tych bardzo wczesnych wersji AB, jakie w tej chwili jeżdżą po drogach... Mimo to trwa ogólnoświatowa masakra na drogach, w kontekście której dylematy, o których piszesz wydają mi się, jakby to powiedzieć.... do wzięcia pod uwagę w drugiej kolejności?

Zabić jednego czy sześciu, dylematy wagonika i inne? To moim zdaniem wyjątkowe, dwuznaczne sytuacje, jakich wydarzy się na świecie kilkadziesiąt, kilkaset rocznie? Dlaczego zaczynać od wyjątków? Zasada jest inna. Zasadą są miliony zabitych, kalek i rannych co roku, co roku, co roku - więcej niż na wszystkich wojnach i przy napadach bandytów razem wziętych. Więc chyba moralne będzie oddanie SI kontroli nad AB, a zatem nad ruchem w miastach, a zatem po trochu - nad organizmem zwanym społeczeństwem...

Miliony uratowanych, warto chyba? Będzie trochę niesprawiedliwości, także. Ale ile zdrowia i życia ocaleje...

Liczby.... Tak właśnie AI przejmie kontrolę nad ruchem drogowym. A potem to samo w innych dziedzinach, w miarę jak statystyki pokażą, że SI mogłaby nam pomóc uniknąć kolejnych nieszczęść...

Komentarz napisałeś chyba nie pod tym artykułem :)

Cały cykl artykułów miał pokazać potrzebę przepływu praw moralnych będących fundamentem cywilizacji i relacji.

---------------Prawo moralne------------->

UNIWERSUM-->Kreatorzy-->MY -> SI-->

Podejmując działania technologiczne zapominamy o równoległej bazie moralnej.

Żeby nie nudzić tylko teorią, którą niektórzy mogą uznać za zbędną dziś i niepotrzebną (co on tam bredzi o jakiejś sztucznej entelegnecji), przytoczyłem przykład pojazdów autonomicznych, które już dziś wyjeżdżają na drogi, a ich twórcy zastanawiają się nad rozwiązaniem kwestii moralnych. De facto nie piszę o perspektywie 200 lat tylko o dniu dzisiejszym.

Już dziś powinniśmy się zastanawiać nad prawami dla SI, skoro nad nią pracujemy i ją powoli tworzymy.

Przykładowo, jeżeli za 2 lata w ramach Blue Brain "coś" się narodzi nie będziemy kompletnie gotowi. Zabraknie wyprawki, łóżeczka i pieluszek dla "bobasa". Dobrzy rodzice mają gotową wyprawkę... Skoro Elon Musk, twórca autonomicznej Tesli widzi problem z SI, to chyba coś w tym jest?

P.S. Zgadzam się z Tobą, że ocalimy wiele istnień. Organizację ruchu drogowego uważam, za wielką rzeźnię i cywilizacyjną pomyłkę. Tu też ktoś nie planował...

Nigdzie nie kwestionowałem sensu sanacji systemu, ani wprowadzania "autochodów". :)

Sorki, masz rację.

To jest do innego Twojego artykułu. Dałem go tam także.

Co do moralności i SI, prace są moim zdaniem dość zaawansowane. Literatury są już sporo. Przynajmniej kilka z największych uniwerków ma całe wydziały lub kursy temu poświęcone. Poza tym powstała z inicjatywy całego światowego mega-info-tech specjalna fundacja z takimi samymi celami, z kolosalnym budżetem:

https://www.partnershiponai.org/

Problemem jest natomiast z pewnością popularyzacja i edukacja, i tu robisz doskonałą robotę ostatnio :)

Przeglądnąłem dział News i są ... bardzo lakoniczni :)

2 newsy na ... rok. Bardzo ogólne i okrągłe słowa na całej stronie.

Fundację tworzą same światowe tuzy, nawet Amnesty International i Zalando tam jest :)

Ciekawe ...

Nie widziałem Muska...

Zgadzam się.

Stwierdziłem, że w debacie publicznej dwa zdania pomiędzy Zuckerbergiem i Muskiem w tak ważnej sprawie to czysta kpina. Mój głos nie ma znaczenia, ale kilka osób wciągnie może w dyskusję. Może ktoś się zamyśli...

Poza tym, że piszesz sensownie, piszesz na Steemit.

Twój głos ma przynajmniej potencjalnie ogromne znaczenie, jak wszystkie nasze debaty tutaj. Na głównej po angielsku było trochę tekstów o tym, że ekosystem Steemita i innych blockchain media - ma szansę na ominięcie tej polaryzacji, w jaką wpadły Facebooki i inne. Szansę na otwarty dialog ideowy. Dziś nawet Obama o tym mówił w BBC.

(NIE o Steemit, tylko o szkodliwości social media 1.0)

http://www.cnn.com/2017/12/27/politics/obama-prince-harry-interview-social-media-intl/index.html

Uciekłem z Face bo nie mogłem znieść kolejnego kotka i tysięcznego mema...

Tutaj, codziennie dowiaduję się coś nowego.

Mózg ma co robić :)

Może rzeczywiście do kogoś dotrę :)

W górę serca !

Chciałbym zauważyć, że jako istoty moralne zabijamy świnie.

Zasady moralne są kwestią arbitralną.

Gdyby istniała moralność w sensie uniwersalnym, ok. Jeśli jednak nie istnieje, wtedy to co nazywasz moralnością jest tylko inną nomenklaturą dla problemu przed którym próbowałeś uciec.

Prowadzimy też badania by "hodować tkanki" w celu zaspokajania głodu. Nie wiem, na ile jest to uzasadnione ekonomicznie, a ile "moralnością".

Sam wiem, że zabijanie jest złe i zjadając mięso mam dyskomfort psychiczny.

Jeden z naukowców zrobił badania dot. zasad moralnych na próbie 200 000 ludzi różnych, płci, wieku, środowisk i miejsc na świecie i okazuje się, że wyniki są zbieżne. Mamy w sobie uniwersalną moralność.

P.S. Ciekawe czy pytał psychopatów i seryjnych morderców? Z drugiej strony można ich uznać, za "uszkodzone" egzemplarze. W próbie wyniki skrajne odrzucamy...

'Jeden z naukowców zrobił badania dot. zasad moralnych na próbie 200 000 ludzi różnych, płci, wieku, środowisk i miejsc na świecie i okazuje się, że wyniki są zbieżne. Mamy w sobie uniwersalną moralność.'

Zasadniczo zgodzę się z tym, ponieważ sam swego czasu dotarłem do takich badań.

Jakkolwiek, do pewnego stopnia jest to generalizacja.

Problem pojawia się wtedy, kiedy zaczynamy rozważać kwestie 'niejako' poboczne, tj. rozpatrujemy zagadnienie w sposób szczegółowy, bez pominięcia CZEGOKOLWIEK.

Wiele jest sytuacji, w których dochodzi do zgrzytu, weźmy chociażby problemy eutanazji, aborcji, kontroli urodzen etc.

Moralność nie jest spójnym systemem, nie jest koherentna.

Skoro zatem dla każdego problemu nie jestem w stanie wyprowadzić jednego, niezmiennego rozwiązania, to pojawia się przestrzeń na interpretację, czy właśnie arbitralność.

Oczywiście, tak jak w nauce funkcjonuje pojęcie granicy błędu, tak i na gruncie moralności moglibyśmy pewne kwestie 'pomijać', ale jak długo da się tak robić?

Dla mnie moralność jest płynnym konceptem, u którego podstaw leży pominięcie pewnych zmiennych.

A dlaczego?

Ano właśnie dlatego, że zasady moralne nie wynikają na gruncie logiki.

Zasady moralne są przyjmowane ad hoc, a potem rozpatrywane z 'fragmentarycznej' perspektywy systemu, bo kompletnego systemu nie ma.

Inaczej się nie da, bo zaczelibyśmy popadać w sprzeczności.

To jest dopiero widoczne na gruncie detali, które wspomniane badania pomijają.

Dlatego moralność "u mnie" pochodzi od Kreatorów :) Skoro są starsi ( mimo, że nieudolni) to może coś tam o świecie wiedzą...

"P.S. Ciekawe czy pytał psychopatów i seryjnych morderców? Z drugiej strony można ich uznać, za "uszkodzone" egzemplarze. W próbie wyniki skrajne odrzucamy..."

Słyszałem kiedyś coś takiego, że parafrazując, jeśli coś pojawia się w cyklicznie, to nawet jeśli występuje w małych ilościach, nie jest już anomalią.