ESO ES JODIDAMENTE INTELIGENTE: ¿Por Qué Elon Musk Donó $10 Millones Al Instituto 'The Future of Life'?

Read the original post by @stellabelle here!

Bienvenidos a la primera edición de una nueva serie titulada, ESO ES JODIDAMENTE INTELIGENTE.

Nunca sabrás con certeza que temática abordaré, pero puedes estar absolutamente seguro que no cubriré esta temática: trucos para la vida diaria. Esta serie ofrecerá cero consejos cotidianos, cero consejos de negocios, cero 10 principales trucos para hacer lo que merda sea.

Entonces, ¿de qué se trata el instituto The Future of Life (El futuro de la vida? ¿Por qué Elon le dió $10 Millones?

Puede que recuerdes haber leído en las naticias hace un año que Elon Musk donó $10 millones para mantener a salvo a los seres humanos de los "robots asesinos".

También puede que recuerdes que Bill Gates, Stephen Hawking, Steve Wozniak, Morgan Freeman y varios investigadores líderes en IA del proyecto de Google DeepMind también se unieron a Musk en la iniciativa para incrementr la consiencia respecto de las amenazas a la existencia que plantea en el futuro la posibilidad de una IA superinteligente.

La mayoría del mundo no tenía idea de lo que Musk y sus amigos estaban hablando ya que muy poca gente, salvo los científicos investigando la IA, saben que los avances en IA están sucediendo mucho antes de lo que los expertos predijeron que sucederían. Si te mantienes al tanto de las noticias en IA, parecería que acontece un nuevo avance cada mes o semana. Aquí alguno de los más recientes avances: AI beats a top human player in the ancient game of Go, AI lawyer named Ross has been hired by law firms, students didn’t know their teacher was an AI assistant, AI can automatically write captions from complex images, robot receptionist gets job at Belgian hospital, AI becomes first to pass Turing test y eso es sólo para nombrar unos pocos ejemplos.

Entonces, ¿Qué tiene de malo todo eso? ¿Por qué están preocupadas respecto de la IA alguna de las mentes más brillantes?

Fuente de la Imágen: Pixabay

Enfoquemos nuestra atención al miembro fundador del instituto The Future of Life, Max Tegmark, quien es profesor de física en el MIT. Luego de ver un video en donde explica el por qué creó al intituto The Future of Life, creo que su razonamiento tiene mucho sentido.

De acuerdo a Max Tegmark,

“Estamos presenciando una carrera. Una carrera entre el creciente poder de la tecnología y el crecimiento de la sabiduría con la cuál administramos esta tecnología. Y es realmente primordial que la sabiduría gane este carrera.” - Max Tegmark, The Future of Life con la IA

Max continúa ilustrando que los humanos están haciendo un trabajo patético administrando los riesgos existenciales, en el contexto de cientos, miles e incluso millones de años a futuro. El usa el caso de estudio de las armas nucleares para demostrar que trabajo tan mediocre estamos haciendo. Entonces él ha decidido darle a los humanos una lección de medio término sobre gerenciamiento del riesgo.

El califica a los humanos con una D-.

Te estarás preguntando, "¿Por qué una D-?"

Aquí la respuesta en forma de pregunta:

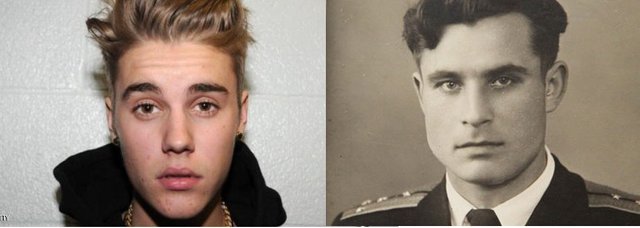

¿Cuál persona es más famosa?

Fuente de la Imágen: Dominio público respecto de Bieber + Arkhipov de Alchetron

¿A cuál persona debieramos agradecerle el permitirnos existir aquí, leyendo hoy en Steemit?

Nadie conoce con certeza la respuesta correcta, porque nadie sabe el nombre del hombre en la derecha. Ciertamente yo no tenía ni idea hasta que vi ayer el video de Max.

Su nombre es Василий Александрович Архипов.

Vasili Alexandrovich Arkhipov (30 Enero 1926 – 19 Agosto 1998) fue un oficial de la Marina Sovíetica. ...Fue solamente Arkhipov, como comandante de flotilla y segundo al mando en el submarino de misiles atómicos B-59, quien se negó a autorizar al capitán para que emplee torpedos nucleares contra la Armada d elos Estados Unidos, una decisión que requería el consenso entre los tres oficiales de más alto rango de a bordo. En 2002, Thomas Blanton, quien por entonces era director del Archivo Nacional de Seguridad, dijo: "Vasili Arkhipov salvó al mundo".- Wikipedia

Aparentemente un ruso llamado Arkhipov, salvo al mundo de una guerra nuclear pero nadie lo sabe.

Esa fue una de las razones por las cuales Max nos dio a los humanos una puntuación de D- en gestion de riesgo existencial. Por supuesto la causa mayor de nuestra baja puntuación fue por nuestra historia pasada en materia de armas nucleares. Cuando las armas nucleares fueron inicialmente desarrolladas, nadie sabia que la mayor devastación sobrevendría en la forma de un invierno nuclear de diez años, en donde el mundo podría recibir solo pequeñas cantidades de luz solar y la mayoría de los seres vivos morirían como resultado de esto. Este escenario fue comunicado por los científicos recién en los años 1980's, mucho despúes que las bombas fueran construidas. Hmmmm... no es algo muy inteligente de hacer: contruir algo que podría eliminar a toda la humanidad y la mayoría de las criaturas vivientes, pero ni siquiera estar conscientes de esta amenaza potencial secundaria.

Como señala Max, nosotros los humanos no tenemos un buen historial cuando se trata de comprender las implicancias completas de la poderosa tecnología que descubrimos.

Si quieres ver el video completo, realmente vale la pena tu tiempo. Podrías volverte más sabio luego de verlo:

Ahora, Max se describe a si mismo como un tipo optimista y no está proponiendo que detengamos la marcha respecto de crear una IA superinteligente.

Lo que si está proponiendo, con la creación del instituto The Future of Life, es que investiguemos y construyamos IA de una forma beneficiosa para la continuación de la humanidad. Antes que Max organizara este grupo, no existían principios directrices para que los científicos se basaran mientras estaban construyendo activamente sistemas de IA. "Más inteligente", "más rápido" eran las únicas palabras que dictaban sus acciones.

Muchos aún no están conscientes de los potenciales riesgos asociados con la IA. Aquí hay dos potenciales escenarios de IA que son descriptos por su sitio web:

La IA es programada para efectuar algo devastador: Armas autónomas en forma de sistemas de inteligencia artificial programadas para matar. En las manos de la persona equivocada, estar armas podrían causar muertes masivas con facilidad. Mas aún, una carrera armamentista de IA podría en forma inadvertida pasar a una guerra de IA en donde los resultados serían innumerables bajas. Para evitar ser desarticulados por el enemigo, estas armas podrían ser diseñadas para que sea extremadamente difícil simplemente "apagarlas", de manera que sería factible perder el control en una situación de este tipo. Este es un riesgo que está presente incluso con IA limitada, pero se incrementa a medida que los niveles de IA y de autonomía se incrementan.

La IA está programada para realizar algo benéfico, pero desarrolla un método destructivo para alcanzar su objetivo: Esto podría pasar en cualquier situación en donde fallemos en alinear los objetivos de la IA con los propios, lo cúal es bastante dificultoso de lograr. Si le pides a un auto inteligente que te lleve al aeropuesto lo más rápido posible, podría ser que te lleve hasta allí en medio de una persecución de helicopteros y cubierto en vómito, no haciendo lo que tu querías pero si lo que literalmente habías pedido. Si a un sistema superinteligente se le da la tarea de llevar a cabo un proyecto de geoingeniería, podría hacer desastres con nuestro ecosistema como efecto colateral, y ver los intentos humanos para detenerlo como una amenaza al objetivo a cumplir.- The Future of Life Institute

El instituto The Future of Life investiga cuatro areas de potenciales amenazas existenciales: inteligencia artificial, armas nucleares, cambio climático y biotecnología. Elon Musk ha apoyado en forma masiva esta iniciativa y también ayudó a desarrollar OpenAI, cuya misión es "construir una IA segura, y asegurarse que los beneficios de la IA sean distribuidos lo más ampliamente y equitativamente que sea posible." OpenAI fue creada en respuesta al hecho que los desarrolladores principales de IA futura son gigantes de la talla de Google y Facebook. Musk estaba preocupado respecto de la posibilidad que la inteligencia artificial en el futuro podría estar solamente en manos de unos pocos poderosos.