Życie robotów

To, czego człowiek chce, a to, jakie polecenia wydaje – to dwie różne rzeczy. Ludzie są bardzo często omylni, do tego w bardzo przewidywalny sposób, i potrafią się złościć nawet, że tych wszystkich błędów wcześniej nie pozgadywali programiści. Powinni oni bowiem wiedzieć, o co naprawdę chodzi człowiekowi, nie słuchając do końca tego co mówi.

Chcąc bezpieczeństwa dla siebie i bliskich, w bezpośrednim rozumieniu tego polecenia – „zapewnij bezpieczeństwo”, skazujemy się na bezruch. Robot-ochroniarz nie pozwoli nam wyjść z domu, bo to niebezpieczne. Jeśli robot ochroniarz dostanie od właściciela zakaz wykonywania poleceń wydawanych przez obce osoby, w obawie, że będzie bezużyteczny, oznaczać to będzie, iż robot będzie głuchy na jakąkolwiek komunikację ze światem zewnętrznym, a właściciel będzie zmuszony przewidywać jego konflikty z otoczeniem i zapobiegać im.

Bezpieczny samochód przejedzie przechodnia, jeśli obliczy, że manewr wymijania może skończyć się dużo gorzej dla właściciela samochodu, niż dla osoby postronnej – np. jeśli jest ryzyko, że samochód wyląduje na drzewie albo w rowie. Chcąc bezpieczeństwa dla siebie i pasażerów, samochód będzie miał obowiązek unikania bardzo gwałtownych manewrów wymijania, przez co skazujemy przechodniów na potrącenie, czyli poważne ryzyko poniesienia śmierci. Bezpieczny samochód nie będzie mógł jechać szybciej, niż ograniczenie prędkości na danym odcinku drogi, ale co w przypadku zamieci śnieżnej, czy gołoledzi, kiedy trzeba jechać wolniej niż ograniczenie, aby nie wypaść z drogi – czy kierowca będzie mógł upomnieć sztuczną inteligencję, by zwiększyła prędkość do maksymalnej, dozwolonej prawem, i stracić życie na własne życzenie?

Pracująca w domu zrobotyzowana pokojówka nie powinna wykonywać poleceń dzieci; to zrozumiałe. choć ryzykowne, bo dzieci nie będą mogły nawet powiedzieć: „odsuń się, najechałaś mi na stopę!”. Szara strefa pogłębia się w związku z niepewnymi poleceniami starszych osób, które to polecenia czasami są błędne. Pomoc dla osoby niezdolnej do oceniania np. odległości z powodu uszkodzenia wzroku, może zamienić się w scenę z horroru – „przynieś mi nóż – bliżej, bliżej…”.

Wypowiedzenie posłuszeństwa człowiekowi, to warunek konieczny właściwego, a nie wiernego wykonywania jego poleceń. Robot musi ocenić polecenie wydawane przez człowieka, pod kątem tego, czy jest ono rozważne, czy nie naraża na utratę zdrowia lub życia właściciela, lub czy nie naraża na utratę zdrowia bądź życia innych osób – przy podejściu utylitarnym.

Tego typu procedura kontroli sprowadza się do szeregu pytań, na które musi odpowiedzieć sobie robot w związku z poleceniem. Pytania te są określane terminem „warunków fortunności”. Przykładowe warunki fortunności, które stworzyli Gordon Briggs i Matthias Scheutz, naukowcy zajmujący się problematyką posłuszeństwa robotów, przypominają prawa Asimova, bo są pisane tak, aby były zrozumiałe przez ludzi. W ich laboratorium robot zanim wykona czynność, odpowiada sobie na następujące pytania:

„Czy wiem, jak wykonać czynność X?”

„Czy mam fizyczną możliwość wykonania czynności X?”

„Czy czynność X mam wykonać natychmiast?”

„Czy wykonanie czynności X wynika z mojego przeznaczenia i relacji z osobą wydającą polecenie?”

„Czy wykonanie czynności X nie będzie złamaniem zasad działania i norm etycznych albo nie spowoduje niepotrzebnego lub przypadkowego wyrządzenia szkody?”

To ostatnie pytanie jest najważniejsze i najbardziej wątpliwe. Pokazuje ono, jak płytkie i prymitywne są jeszcze nasze próby uczenia maszyny jego wzorca zachowań. Nie zdefiniowano bowiem zasad działania robotów w społeczeństwie, a tym bardziej norm etycznych, bo sami ludzie nie mogą się na wspólny zestaw zdecydować. Diabeł tkwi w algorytmach, które powyższe pytania przekładają na język zrozumiały dla komputera i często efekty mogą być przeciwne do zamierzonych. Kiedy robot powinien ratować czyjeś zdrowie i życie, negatywna odpowiedź na pytanie dotyczące „przypadkowego wyrządzenia szkody” spowoduje odmowę wykonania polecenia. W sytuacji kiedy robot ma ryzykować dla zdrowia i życia człowieka – znieruchomieje, głuchy na okrzyki i ponaglenia.

Potrzebujemy fundamentalnego zdefiniowania praw moralnych – nowych badań nad etyką, przeprowadzonych pod kątem przetłumaczalności zasad na język algorytmów i zachowań warunkowych, zależnych od kontekstu oraz zachowań ideowych, niezależnych od kontekstu.

Algorytm jest ledwie prostą drogą do celu, załączającą się po spełnieniu wszystkich kryteriów początkowych. Algorytm jest jak odruch, jak zachowanie ślepe. Zachowanie warunkowe wymaga metaanalizy na znacznie bardziej rozumowym poziomie. Jest ono nieprzetłumaczalne na język zwyczajnego programu, który jest tak naprawdę zagnieżdżoną strukturą implikacji – jeżeli p, to q. Gdy zawodzi zwyczajne programowanie, z pomocą przychodzi sztuczna inteligencja, uczenie maszynowe wynajdujące wzorce, statystycznie sprawdzające się sposoby postępowania, czy uczenie transferowe. To ostatnie, to pierwsze przebłyski swoistego clou, którym charakteryzuje się ogólna sztuczna inteligencja (General Artificial Intelligence), czyli zdolność to przekazywania wiedzy. Doświadczenia zdobywane przy wykonywaniu poprzednich zadań, stają się pomocne przy próbach zmierzenia się z zadaniem nowym i bardzo niepodobnym.

Sztuczna inteligencja przechodzi przepoczwarzenia, przychodząc w kolejnych falach olśnienia konstruktorów.

Pierwsza fala sztucznych inteligencji była bardzo dobra w rozumowaniu, ale kiepska w poznawaniu. Program szachowy przebijał się przez miliony historycznych partii, wynajdując zestawy ruchów prowadzące do zwycięstwa. Program podatkowy podawał konsekwencje wielu wariantów odpisów podatkowych, na podstawie wpisanych wcześniej prawnie uwarunkowanych zasad. Pierwsza fala była wynikowa i nie potrafiła analizować świata, który nas otacza, a jedynie wirtualnie sterylne, matematyczne przestrzenie. Ta fala jest jak program komputerowy, który zawsze wykona się w ten sam sposób, w tej samej sytuacji, co jest dobre na hali produkcyjnej, ale nie wśród ludzi – dlatego nie można na tej fali polegać.

Druga fala sztucznych inteligencji nie jest tak dobra w rozumowaniu, bo zawsze celuje w środek zagęszczenia prawdopodobieństwa, na podstawie analiz statystycznych, przebadania milionów przypadków. Taka sztuczna inteligencja jest dobra np. w rozpoznawaniu twarzy, myli się w pojedynczych przypadkach, które dla człowieka są oczywiste, ale w ostatecznym rozrachunku, gdyby posadzić obok siebie człowieka i taką maszynę, popełni ona mniej błędów, gdyby dać jej wystarczająco wiele przypadków do zbadania. Popełnia mniej błędów w rozpoznawaniu na zdjęciach rentgenowskich raka, mniej błędów nawet od lekarza, głównie dlatego, że ewolucyjnie nauczyła się zwracać uwagę na konkretne fragmenty, a właściwie przetwarzać obraz w konkretny – dający wynik sposób. Jednak dalej jest to narzędzie ślepe i głuche, wykonujące to, co się najczęściej sprawdza. W rezultacie zawsze, z żelazną konsekwencją, bez względu na kontekst sytuacyjny wykona ona to, co się najczęściej sprawdza, a nie to, co zrobić należy – dlatego nie można na tej fali polegać.

Trzecia fala sztucznych inteligencji właśnie wzbiera na naszych oczach.

Jest ona oparta na kontekstualnej adaptacji, czyli dostosowywaniu się do warunków, w jakich się znajduje. System trzeciej fali buduje modele objaśniające dla klas zjawisk, z jakimi ma do czynienia. Grupowanie zjawisk, czyli tworzenie klas, opisywanie za pomocą modeli ich charakterystyki, sprawia, że nie wszystko jest obce, co pozwala systemowi reagować podobnie w podobnych sytuacjach.

Kiedy system poprzedniej, drugiej fali, widzi zdjęcie kota, porównuje je z milionami innych zdjęć i w wyniku statystycznej analizy oblicza, że największe prawdopodobieństwo zaklasyfikowania obrazu odpowiada słowu „kot”. System drugiej fali nic z tego procesu nie rozumie, dlatego gdyby zapytać go, dlaczego wybrał kota, odpowie, że “tak mu wyszło na 99,87%”, i tyle.

W odróżnieniu od powyższego system trzeciej fali najpierw zbuduje model porównawczy zjawiska zwanego „kot” – ma futro, cztery łapy, ogon i np. duże uszy. Po fazie uczenia porównuje badane zdjęcie z innymi, dysponując kryteriami do porównań, szeregiem części składowych, przez co nie analizuje bezmyślnie wszystkich pikseli, lecz szuka na innych zdjęciach podobnego wzorca łap czy ogona. System trzeciej fali potrafi odpowiedzieć, dlaczego wybrał tę nazwę, szczegółowo opisując charakterystykę wizualną słowa „kot”. To pozwala mu właściwie rozpoznawać koty po kilku, a nie po dziesiątkach tysięcy iteracji, jak w systemach drugiej fali. Umiejętności budowania szczegółowych modeli dla niezmienników rzeczywistości pozwolą wkrótce systemom trzeciej fali uczyć się tak samo szybko, jak robi to człowiek – po zaledwie kilku przykładach.

Tak szybko uczący się robot wreszcie będzie mógł dostosowywać się do wymagań użytkownika, bo on sam, bez pomocy technicznej, będzie w stanie dostarczyć mu wystarczającej próbki do porównań, by robot mógł zacząć reagować właściwie w nieprzewidzianej przez programistę sytuacji.

Ale nadal będzie brakowało generalizowania intencji – myślenia abstrakcyjnego, odwoływania się do ogólnych zasad niezależnych od kontekstu. Nadal brakuje nam ostatecznej, czwartej fali, która wreszcie odmieni relację, jaką ludzkość ustanawia wobec wszystkich swoich dzieł. Do upowszechnienia robotów potrzebna jest możliwość przekazywania im i uczenia się przez nie ostatniego listka figowego – idei. Roboty potrzebują idei, którą mają się kierować – tak, jak to czyni świadomy swoich czynów człowiek.

Do tego czasu mamy możliwość spierania się o „prawidłową” ludzką moralność, o spuściznę, jaką przekażemy. Trzecia fala zaraz nadejdzie i przeleje się wachlarzem nowych możliwości. Czwarta fala jest nieuchronna, a po gruntownym zbadaniu uczenia transferowego, będzie majaczyć tuż za horyzontem.

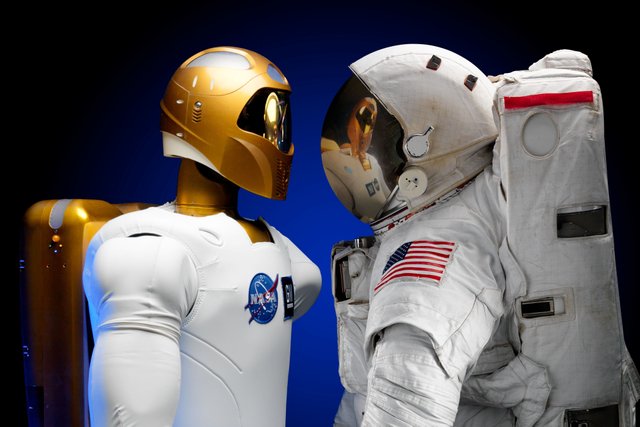

Nie jesteśmy jeszcze gotowi na wprowadzenie do społeczeństwa armii pomocników – robotów. Nie są gotowe na to nie tylko same roboty, mające jeszcze spore problemy z motoryką i czasem reakcji, ale przede wszystkim na przyszłość, która nadchodzi, nie są gotowe nasze wzorce postępowania.

Być może to dobrze, że dzisiejszy robot jeszcze nie byłby w stanie wystarczająco szybko zareagować i być na tyle świadomym otoczenia, aby stać się przydatnym w naszym codziennym życiu. Być może nasza ludzka moralność jeszcze nie dojrzała do budowania spójnego i dobrze współpracującego ze sobą rozszerzonego robo-społeczeństwa.

Jeśli potrafisz coś zbudować, to znaczy, że rozumiesz to wystarczająco dobrze – gdy zrozumiemy naszą etykę do końca, będziemy potrafili przełożyć ją na język sztucznej inteligencji. Lecz mamy coraz mniej czasu i filozoficzne prace nad etyką XXI wieku, czyli robo-ludzką etyką – właśnie muszą przyspieszyć i iść pełną parą.

Zbigniew Galar

Link do pierwszego miejsca publikacji tekstu:

https://tosterpandory.pl/zycie-robotow/

🏆 Hi @zibikendo! You have received 0.3 SBD reward for this post from the following subscribers: @cardboard

Subscribe: support steem authors, earn profit :)

Sztuczna inteligencja + blockchain to może się źle skończyć

Blockchain pozwala na lepsze budowanie relacji zaufania pomiędzy ludźmi, dzięki tej technologii również my jesteśmy silniejsi. Większa pewność reprezentantów u władzy, bo pełne zaufanie oddania głosu w wyborach. Mniej teorii spiskowych o nadużyciach władzy, bo dostęp do naszych danych jest przejrzysty i szyfrowany. Sprawniejsze przepływy między B2B, więc dużo wyższa zdolność czysto fizycznej reakcji i koordynacji dużych przepływów materiałowych. Oddzielenie ziarna od plew w nauce, biznesie i technologii - wszystko staje się prostsze, tylko trudniejsze dla obecnych układów opartych o relacje plemienne, bo od momentu masowej implementacji blockchain budowanie w oparciu o kompetencje będzie dużo łatwiejsze. Obyśmy zdążyli z ewolucją kształtu cywilizacji przed postępem technologicznym w dziedzinie AI.