[논문 소개] How good is my GAN?

- 논문 정보

- 논문 제목: How good is my GAN?

- 논문 링크: https://arxiv.org/abs/1807.09499, https://hal.inria.fr/hal-01850447/document

- 학회 정보: ECCV 2018

오늘 소개들리 논문은 "How good is my GAN?"이란 논문입니다. 논문 제목이 ... 그렇습니다. 올해 ECCV에 나오는 논문으로 제목에서 알 수 있듯이 GAN의 성능을 측정하기 위한 방법에 관한 논문입니다. 그렇다고 모든 GAN에 대해서 다 성능을 평가할 수 있는 방법을 제안한건 아닌거 같고요. classification에 관련된 conditional GAN에 제한적으로 사용할 수 있는 방법에 대한 내용이라고 보면 될 거 같습니다.

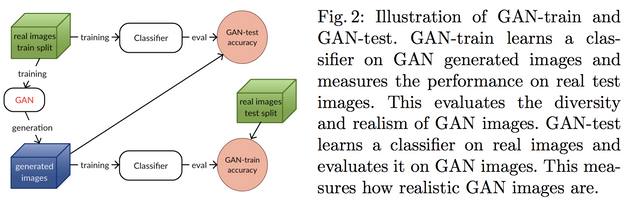

일단 논문의 내용은 한두줄이면 설명이 끝날거 같이 간단한 정의를 사용하고 있습니다. 논문에서 제안하는 GAN을 평가하는 방식은 두가지 텀을 이용합니다. GAN-train과 GAN-test입니다. 두 텀 다 classification을 하는 netwrok 모델을 기반으로 합니다. GAN-train은 GAN으로 생성된 이미지로 training set을 구성해 classification model을 학습시키고, 실제 이미지로 이루어진 test set으로 성능을 평가하는 것이고, GAN-test는 그 반대입니다. GAN으로 생성된 영상이 실제 이미지와 더 비슷하다면, 그 diversity와 분포가 비슷하다면 GAN-train, GAN-test에서 실제 이미지에서와 유사하게 충분한 recall과 precision을 보일 수 있다는 논리입니다.

뭐 논문에서도 밝혔지만, 기존에도 비슷한 논리의 정의가 없었던 건 아닙니다. 논문에서 소개된 inception score와 Fr´echet Inception distance도 실제 데이터와 생성된 데이터간의 분포에 대해서 직접 혹은 간접적으로 비교하려고 한거 같은데, 제안하는 방법이 더 실제적인거 같은 느낌도 있습니다.

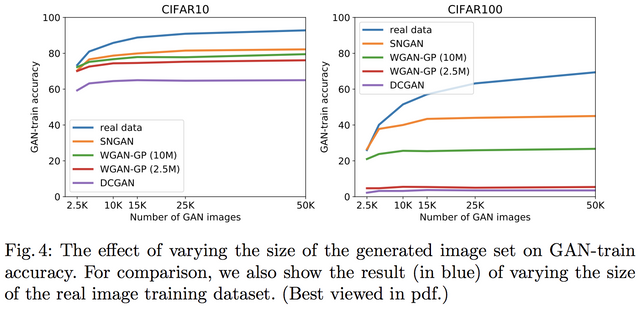

뭐.. 결과는 다른 거보다 잘 되고 그런다는 거지만, 결과 중에 눈길이 갔던 몇 표는.. fig.4에서 보여진 GAN 이미지 수에 따른 GAN-train 수치입니다. 실제 영상을 꾸준히 넣는 것과는 확연히 달리 saturation되는 부분이 눈길이 갔습니다.

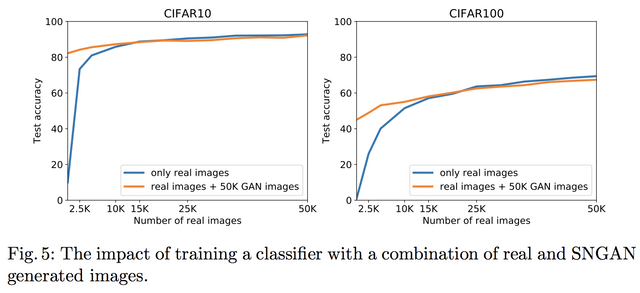

그리고, 비슷한 현상이 data augmentation으로써의 GAN 사용에서도 나오는데, 아래와 같이 예상대로 데이터가 적을 때... 약 15k 이하일때 도움이 되나, 그 이후에는 그닥..

논문을 처음 읽었을 땐, 너무 간단하고 어따쓰지? 그래도 평가 잣대가 너무 없고 그래서 나온건가 싶기도 했는데, 이 잣대로 볼 수 있는 면도 있다고 생각이 들었습니다.

그래도 아직도 GAN을 평가하기 위해서 잣대가 너무 부족하다는 느낌이 있는 상황이긴 한거 같습니다.

오! 논문글을 post하시는군요.

예전 기억이 나네요. 실험하기 위해서 학창시절에 외국논문 번역도 잘 안되는거 번역하면서 삽질했던 추억이 떠오르네요.

논문 한편을 이해하는데 번역하는데 90% 시간이 들고 논문 이해하는데 10% 시간이 들었는데 이해하는데는 얼마 안걸리는데 번역하는데 시간이 너무 많이 걸려서 학창시절에 참 힘들게 공부를 했네요.