[ITA] Una macchina programmata per uccidere?

Salve Steemers, l'argomento che vorrei trattare oggi è molto controverso e tratta di Tecnologia e Scienze Cognitive, ma veniamo a noi.

The Trolley Problem

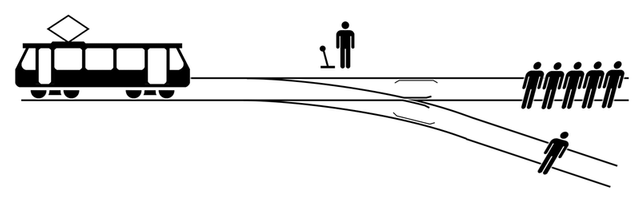

Di questo famoso dilemma ci sono più versioni, consideriamo comunque l'accezione base, fingiamo per un attimo di essere a uno scambio ferroviario, davanti a noi abbiamo una leva che possiamo azionare in un qualsiasi momento.

Sul binario principale ci sono 5 uomini legati e immobilizzati il cui destino è inevitabile, il treno li travolgerà tutti uccidendoli, a meno che decidiamo di azionare lo scambio e deviare il treno sul binario secondario dove però si trova una persona legata alle rotaie e che verrà inevitabilmente travolta e uccisa.

In uno studio1 della Ghent University apparso su Focus 2, che ha riprodotto questo esperimento con dei topi.

E' stato posto a 200 persone il seguente dilemma, sarebbe stata applicata una fortissima scarica elettrica a una gabbia di topi che li avrebbe uccisi, a meno che non si decide di premere un tasto, che devia la scarica a una gabbia secondaria dove è all'interno un solo topo.

Durante la prima fase, dove venivano manifestate le "intenzioni" degli individui partecipanti al test, 2 individui su 3 hanno manifestato l'intenzione di premere il tasto e fare una scelta utilitaristica, sacrificare uno invece di sacrificarne molti.

Nella seconda fase del test invece gli individui sono stati messi fisicamente davanti alla scelta e sotto pressione e come è stato già dimostrato, in questi casi l'emotività del momento è una variabile che non si può escludere, quindi l'84% dei 200 individui partecipanti al test, ha scelto di salvare il gruppo di topi a discapito del singolo topo.

La scarica elettrica era finta, nessun topo è stato folgorato nell'esperimento

Non esistono scelte giuste o sbagliate nel "Trolley Problem", ognuno agirebbe secondo la sensibilità e guidato dalle proprie emozioni, ma allora perché ne abbiamo parlato? e perché parliamo di macchine programmate per uccidere?

Il progresso tecnologico porterà sicuramente in futuro a macchine a guida autonoma, anzi, numerosi prototipi sono già sulle strade per perfezionare la tecnologia.

Ed ecco che qua ci troviamo davanti al problema reale, il software di guida non essendo emotivo dovrà compiere una scelta e tale scelta dovrà essere programmata e codificata da un essere umano, programmando di fatto un computer con la possibilità di uccidere.

I Veicoli a guida autonoma

Le automobili a guida autonoma hanno innumerevoli vantaggi, la guida autonoma non ha bisogno di riposo, è più efficiente, inquina meno e ridurrà di molto il numero di incidenti, si stima una percentuale vicina al 90.

Ma il restante 10% degli incidenti?

Come si comporterà una macchina a guida autonoma se si troverà davanti la scelta tra sacrificare un gruppo di 10 pedoni sulla strada o sacrificare il guidatore? Magari deviando la traiettoria del veicolo contro un muro.

Secondo il problema enunciato precedentemente la scelta "migliore" è salvare molti e sacrificare uno, però in questo caso l'uno è il proprietario dell'auto.

Comprereste mai un auto che decida per voi di sacrificarvi? probabilmente la risposta è no.

Accettereste mai che possa circolare un'auto che per preservare il conducente investa decine di persone? probabilmente anche questo caso la risposta è negativa.

Ma le implicazioni morali non si fermano qua, come dovrebbe valutare un software una famiglia? e un bambino piccolo? una persona anziana? una malata? un pregiudicato? un politico? colui che ha programmato il software stesso? e se dovesse scegliere se investire individuo A rispetto a individuo B?

Gli studi effettuati

Qualcuno dovrà mettere in fila i valori e l'utilità di tutti i tipi di individui e programmare una macchina che decida di sacrificare, a questo proposito sono stati fatti degli studi 3.

Gli studi che vi proporrò possono essere divisi in due gruppi:

- Il primo gruppo sulle implicazioni morali

- Il secondo gruppo sull'effettivo acquisto di uno di questi veicoli

Nel primo studio è stato chiesto a 186 individui se era meglio programmare l'autovettura per salvare il passeggero o salvare dieci pedoni e il 76% ha espresso una preferenza sul sacrificare il passeggero e alla domanda di valutare in una scala da 0 a 100, dove 0 era proteggere il passeggero a tutti i costi e 100 era minimizzare a ogni costo il numero delle vittime la media si è avvicinata molto all'85%, anche se gli individui presi in esame credono che non saranno programmate in questo modo.

Nel secondo studio invece è stato chiesto di scegliere tra sacrificare il passeggero e un solo pedone e il risultato è stato invece inverso, secondo gli intervistati solo il 26% salverebbe il pedone, la percentuale si alza però man mano che aumenta i numero di pedoni.

Il primo studio del secondo gruppo consiste nel capire se le persone comprerebbero una di queste auto, i valori ottenuti sono molto interessanti, praticamente nessuno comprerebbe un'auto che sacrificherebbe i passeggeri se quest'ultimi possono essere membri della propria famiglia, i valori invece si invertono salendo fino al 50% di un'auto che sacrificherebbe anche 10-20 pedoni se a bordo si trovassero i membri della propria famiglia, andando a contrastare quello che fino a qua era stato sostenuto dagli intervistati.

Anche nel secondo studio del secondo gruppo si pone l'accetto sulla differenza di quello che viene ritenuto "moralmente accettabile" alla scelta di acquistare o meno una di queste automobili, se i valori di uccidere un pedone per salvarne dieci o uccidere un pedone per salvarne un altro sono in linea con quello dichiarato, i valori scendono di 10-15 punti percentuali quando si tratta di sacrificare il conducente.

Questi sono solo alcuni dei dilemmi etici che si presentano dinnanzi a noi e dovranno essere risolti prima di veder circolare su strada in modo capillare le automobili a guida autonoma, definendo delle regole su chi possono sacrificare e chi possono salvare.

Bigliografia e Fonti

Hi @deusjudo!

Your post was upvoted by utopian.io in cooperation with steemstem - supporting knowledge, innovation and technological advancement on the Steem Blockchain.

Contribute to Open Source with utopian.io

Learn how to contribute on our website and join the new open source economy.

Want to chat? Join the Utopian Community on Discord https://discord.gg/h52nFrV

Molto interessante, in effetti ci sono moltissimi casi in cui la scelta di un robot o un programma possono sembrare del tutto sbagliati (ricordo la scena di Io Robot quando l'androide decide di salvare l'agente di polizia e lasciar morire la bambina perché le sue probabilità di sopravvivenza erano più alte). Proprio grazie al film ho letto Io Robot di Asimov dove una serie di storie fanno capire le falle nella programmazione e i problemi quando ci si trova in situazioni estreme come quella descritta da te nel post.

Probabilmente nel futuro quelle macchine diventeranno la maggioranza e ci si dovrà arrendere a questo, nella speranza che non capiti la situazione in cui veniamo sacrificati per salvare un gruppo di politici!

Secondo me la soluzione è non guardare l'utilitarismo di chi salvare ma vedere chi ha infranto le regole, se i pedoni sono 100 ma stanno attraversando dove non devono può fare strike e seccarne 100, se tutti i comportamenti fossero standardizzati gli incidenti non ci sarebbero, un incidente deriva da un errore di qualcuno..... e hai trovato il sacrificabile.

Quello che mi preoccupa a me è che uno si possa riprogrammare la macchina con le regole che vuole lui

Questione che mi ero posto non molto tempo fa in una discussione su twitter.

personalmente ritengo che il primo passo da fare sia quello di uscire da un ragionamento di proprietà e passare a quello di utilizzo.

L'auto non è più mia o tua, ma solo in noleggio. Secondariamente il legislatore dovrebbe intervenire per caricare di responsabilità il noleggiatore in luogo del noleggiante. In questo modo il dilemma non verrebbe cancellato, ma credo che questo sia impossibile.

Personalmente ritengo che si dovrebbe fare un ulteriore passo avanti passando dal concetto di automobile a quello di Personal rapid Transit dove la via seguita dai mezzi è indipendente da quella seguita dagli umani, tipo gli ULTra dell'aeroporto di Heatrow.

Non ci avevo pensato. La capacità di riconoscimento facciale sta raggiungendo standard elevati. Potrebbe scegliere di conseguenza in presenza di politici? 😂😂