Robots.txt Spezial

Bildquelle Pixabay

Die Robots.txt Spezial

Wie ich im ersten Beitrag zur Robots geschrieben habe, ist diese kleine Textdatei ziemlich mächtig.

Heute möchte ich auf weitere Besonderheiten eingehen, die ich im ersten Teil nicht erwähnt hatte. Nach meiner Erfahrung liegt die durchschnittliche Aufmerksamkeitsgrenze beim Lesen eines Artikels bei fast genau 1000 Zeichen. Der letzte Beitrag hatte diese Zeichenlänge schon überschritten.

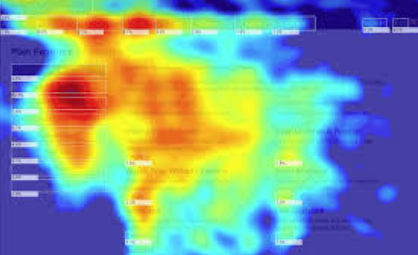

Jetzt fragt ihr euch sicher, wie ich so etwas wie die Aufmerksamkeitsgrenze vom Lesen ermitteln kann. 100% genau lässt sich das nicht ermitteln. Ich habe jedoch auf sehr vielen Kundenseiten Heatmaps zur Verfügung. Diese zeigen mir, wo sich die Maus auf einer Website am häufigsten aufhält. Hat man hier umfangreichere Daten von einigen 10K Sessions zur Verfügung, dann kann man sehr gut schlussfolgern, dass bei langen Beiträgen, über 1000 Zeichen, der untere Bereich der Beitragsseiten weniger von der Maus frequentiert wird. Hier seht ihr eine typische Heatmap:

Die roten Bereiche, sind besonders stark frequentiert. Bei tiefem Rot ist die Konzentration der Mausbewegung in diesen Bereichen am größten. Bei langen Artikelseiten ist es ziemlich gut zu sehen, dass die „Maus-Berührung“ mit der Website, nach unten hin stark abnimmt. Die Heatmap ist demnach eine Art visualisierte Darstellung der Interaktions-Frequenz eines Besuchers mit der Website. Immerhin muss bei längeren Artikeln oft gescrollt werden und diese Berührungspunkte hinterlassen Daten auf der Heatmap.

Zurück zur Robots. Neben den genannten Funktionen des Sperrens oder Erlaubens von Verzeichnissen für spezielle Suchmaschinen-Bots, kann diese kleine Textdatei noch mehr. Wir können z.B. der Suchmaschinen eine kleine Verzögerung mitteilen, eine Zeitspanne, die der Bot warten soll, bevor er anfängt die Seiten zu crawlen. Dieser Befehl sieht so aus:

Crawl-delay: 5

Das sagt dem Suchmaschinenbot, „warte 5 Sekunden ab, bevor du crawlen kannst“. Eine kurze Verzögerung kann gerade bei langsameren Website Sinn machen. Nach meiner Erfahrung sollte ein Delay nicht länger als 15 Sekunden betragen. Einige Crawler sind sonst angepisst und verschwinden ganz schnell wieder.

Wer entweder eine sehr langsame Website (bedingt meistens durch den Hoster) hat, oder wer eine sehr umfangreiche Website (Startseite) hat, der sollte auf jeden Fall ein Delay in die Robots eintragen. 5 oder 10 Sekunden haben sich hier sehr bewährt. Einige Webmaster berichten davon, dass nach dem Einfügen eines Delays der organische Traffic einbrach. Deswegen sollte man darauf ein Auge werfen. Meine Erfahrungen sind nicht immer überall gültig 😊. Wenn ich von großen umfangreichen Seiten rede, meine ich Websites oder Landingpages, die größer als 3 MB sind. Das hört sich nicht viel an, aber im Zeitalter des "Mobil first" sind 3 MB eine Menge. Mein Tipp:

haltet die Startseiten schlank.

Auf Unterseiten kann man sich austoben, aber die Startseite einer Domain muss von allen Pages am besten performen und dazu muss diese zwingend schlank sein.

Würde der Crawler sofort auf einer sehr umfangreichen oder langsamen Website los crawlen, könnte das unschöne Nebeneffekte haben. So kommt es nicht selten vor, dass in den SERPs (das sind die Suchmaschinen-Ergebnis-Seiten, Englisch: Search engine result pages) unschöne Effekte zu sehen sind. Das können abgebrochene Meta-Angaben sein, aber meistens falsch dargestellte Rich snippets. Die Crawler und Bots von den Suchmaschinen haben meistens eine extreme Performance. Hat die Website sehr viele Server-Ressourcen zur Verfügung und passiert da ständig etwas Neues, kommen die Bots auch gerne in mehreren Instanzen vorbei. Ich könnte mir vorstellen, dass hier auf Steemit ständig ein Googlebot unterwegs ist.

Ein besonderes Schmankerl der robots.txt ist, dass man neben Verzeichnissen auch bestimmte Datei-Extensionen von der Indexierung ausschließen lassen kann. Davon machen sehr wenige Gebrauch. Ich denke, die meisten wissen das gar nicht.

Möchte man z.B. Verhindern, dass Bilder von der eigenen Website indexiert werden, kann man das den Bot über die robots.txt mitteilen. Die Syntax dazu ist sehr simpel. Selbst wenn es keine Image-Sitemap gibt, wird Google und Co. immer auch die Bilder einer Website indexieren. Deswegen sind Sitemaps nicht zwingend, aber sie zeigen den Suchmaschinen an, dass die Regeln verstanden werden. Ist keine Sitemap vorhanden, dann hangelt sich der Bot durch die Links einer Website und verfolgt alles was er bekommen kann und indexiert es dann auch. Ist eine Sitemap (xml) vorhanden, dann folgt der Bot genau der darin vorgegebene Struktur.

User-agent: *

Disallow: /*.jpeg$

Disallow: /*.jpg$

Disallow: /*.gif$

Disallow: /*.png$

Disallow: /*.bmp$

Ist das in unsere robots.txt eingetragen, sagt das unserem Suchmaschinenbot, er darf keine Dateien mit den Endungen jpeg, jpg, gif, png und bmp in den Index aufnehmen, egal auf welchem Pfad sich diese befinden. Das funktioniert mit allen Datei-Endungen. Das $ sagt dem Bots, dass nach der Datei-Endung nichts mehr folgt. Wenn doch etwas folgt, ist es nicht verboten.

Eine weitere Besonderheit ist der Ausschluss von Parameter-URL. Gerade bei Shop-Systemen kommen solche dynamischen URLs nicht selten vor.

In dynamischen Parameter-URLs kommt immer ein Fragezeichen (?) vor. Damit Crawler solche URLs nicht verfolgen und eben auch nicht indexieren können, verwenden wir folgende Anweisung in der robots.txt.

User-agent: *

Disallow: /*?

Das bedeutet: Hallo an alle Bots, ihr dürft keinen URLs folgen in denen ein ? enthalten ist.

Achtung, wer noch eine ältere Website mit keiner SEO-freundlichen URL-Struktur oder wer bei WordPress die einfache Permalink-Struktur verwendet, darf diesen Parameter in der robots.txt nicht verwenden, andersfalls sperrt er die komplette Website von der Indexierung aus.

Wie wir gesehen haben, sind die kleinen Dinge oft viel wichtiger als angenommen. Die robots.txt korrekt zu behandeln gehört praktisch zum guten Ton eines Webmasters. Suchmaschinen und hier besonders Google und Bing, wissen es zu schätzen, wenn der Webmaster weiß, was er tut. So streng Google auch sein mag, wer den Regeln folgt, wird belohnt.

© by myself

Ave Atque Vale!

My better search: https://bit.ly/steemit-search

Ich versteh nur Bahnhof - ist aber vielleicht auch besser so...

Beste Grüße.

!COFFEEA

Du hast ein Upvote von unserem Kuration – Support Account erhalten.

Dieser wird nicht von einem Bot erteilt. Wir lesen die Beiträge. (#deutsch) und dann entscheidet der Kurator eigenverantwortlich ob und in welcher Stärke gevotet wird. Unser Upvote zieht ein Curation Trail von vielen Followern hinter sich her!!!

Wir, die Mitglieder des German Steem Bootcamps möchten "DIE DEUTSCHE COMMUNITY" stärken und laden Dich ein Mitglied zu werden.

Discord Server an https://discord.gg/Uee9wDB

Aktueller Kurator ist @mima2606

Und auch heute lasse ich Dir wieder ein paar !trdo da ;)

Congratulations @kryptodenno, you successfuly trended the post shared by @seo-boss!

@seo-boss will receive 3.46838250 TRDO & @kryptodenno will get 2.31225500 TRDO curation in 3 Days from Post Created Date!

"Call TRDO, Your Comment Worth Something!"

To view or trade TRDO go to steem-engine.com

Join TRDO Discord Channel or Join TRDO Web Site

Und auch heute sage ich danke! :-)

Ich bin immer wieder erstaunt 😧 was für ein Wissen manche User haben weis ich doch das ich nie durch diesen Dschungel blicken werde aber sollte es den nötig sein weis ich ja wo ich anklopfen kann geschätzter @seo-boss

VgA 🙂

Jeder ist in etwas gut. Ich kenne keinen Menschen, der nicht eine Sache gut beherrscht :-).

Ja das stimmt. Wir haben alle unsere Fähigkeiten bekommen. Wir müssen nur erkennen und nutzen.

Eine wirklich mächtige Datei

LG Michael

!invest_vote

@mima2606 denkt du hast ein Vote durch @investinthefutur verdient!

@mima2606 thinks you have earned a vote of @investinthefutur !

Congratulations @seo-boss, your post successfully recieved 3.4683825 TRDO from below listed TRENDO callers:

To view or trade TRDO go to steem-engine.com

Join TRDO Discord Channel or Join TRDO Web Site