[논문 소개] Attention U-Net: Learning Where to Look for the Pancreas

- 논문 정보

- 논문 제목: Attention U-Net: Learning Where to Look for the Pancreas

- 학회 정보: Submission to MIDL'18

- 논문 링크: https://arxiv.org/abs/1804.03999

- 소스코드: https://github.com/ozan-oktay/Attention-Gated-Networks

오늘 소개시켜 드릴 논문은 "Attention U-Net: Learning Where to Look for the Pancreas"입니다. 일단 제목에서 논문의 모든 내용을 다 표현하고 있는데, Attention이란 단어가 UNet앞에 존재합니다. 이렇다는 말은 attention 개념을 UNet에 적용했다는 것이고... 이게... 논문의 내용의 다... 입니다.

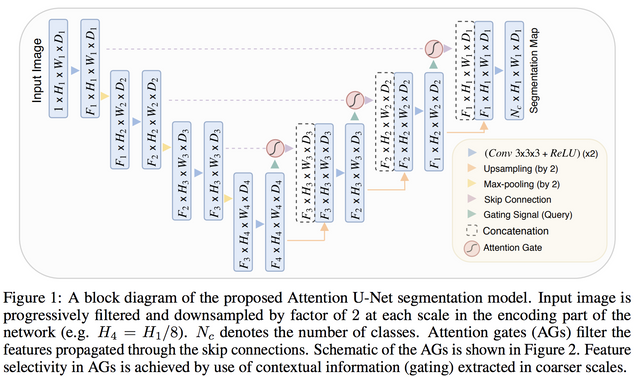

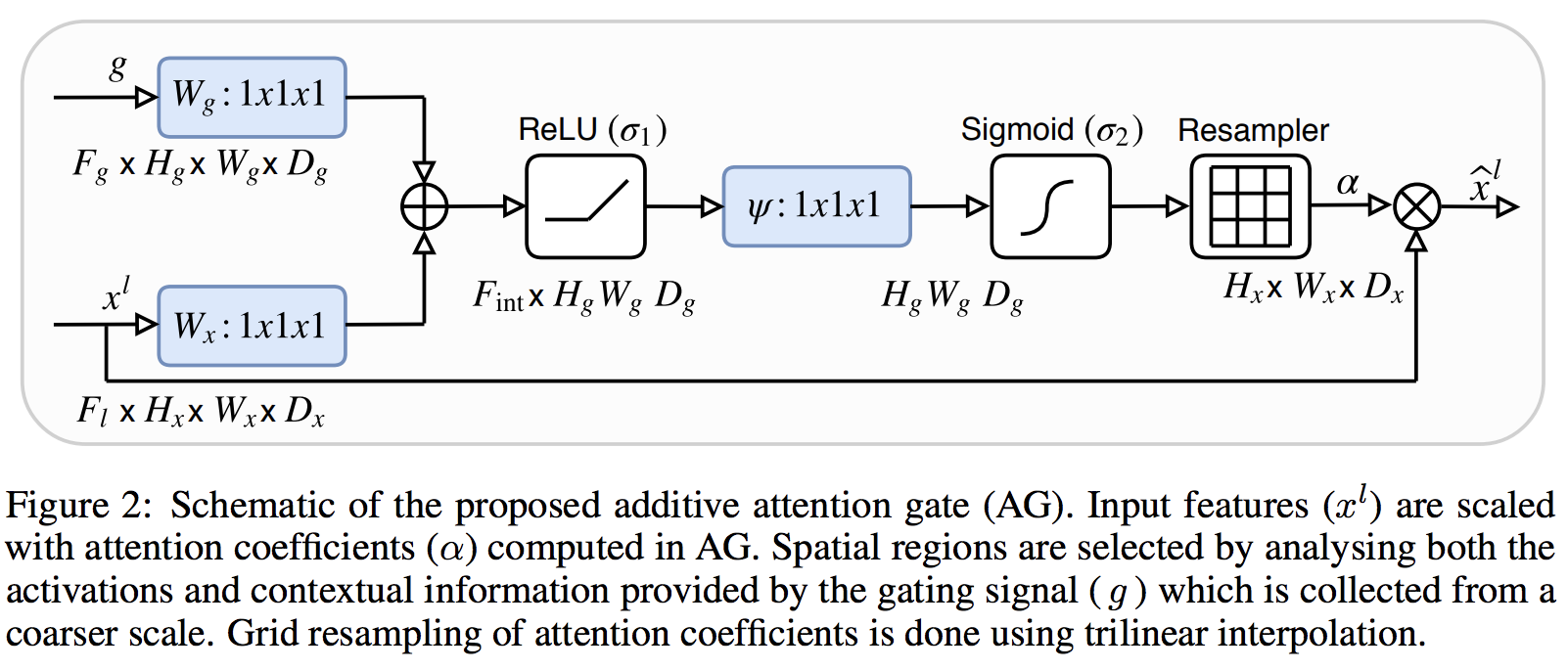

논문에서 제시한 attention U-Net의 구성은 위 그림과 같습니다. 기본적인 U-Net과 비교해 보면 skip-connection 부분에 시그모이드 표시가 똭!! 있습니다. 다시 그 시그모이드라고 표시된 부분을 논문에서 더 자세히 그린 그림을 보면 아래와 같습니다.

이 그림을 보면 이 attention 구조가 작년 CVPR에 나왔던 Residual Attention Network for Image Classification (https://arxiv.org/abs/1704.06904) 논문에서의 attention 구조와 상당히 비슷하다는 것을 아실 수 있습니다. residual 에서의 attention을 구해서 적용되는 구조와 UNet에서 바로 아래 레이어의 결과와 엮여지는 구조가 비슷합니다. 그런데 어떤 attention gate 구조를 사용하냐에 대해서는 이론적으로 증명되었다기 보다는 실험상 성능이 좋았던 구조를 사용하여 설명하는 거 같습니다.

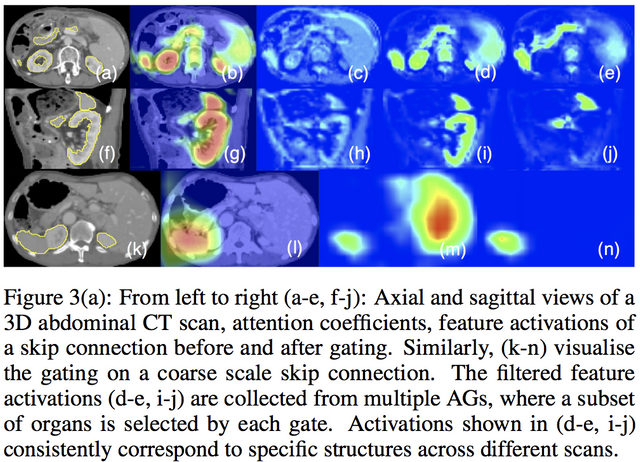

결과가 재밋는데.... 뭐 당연한 거겠지만, 여러 attention gate의 결과들이 서로 좀 다르게 보입니다. attention gate가 서로 다른 위치에서 서로 다르게 보는거 같기도 하고.. 더 예제 사진이 많았으면 하지만..

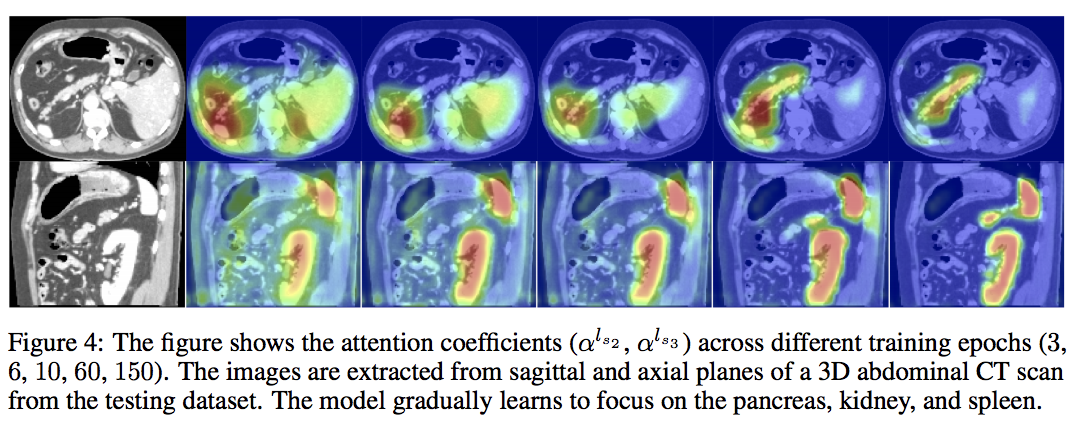

그리고 학습 과정 중 attention gate의 변화를 보시면.. 아래 그림과 같이 점점 더 좋아져서 skipconnection을 따라 노이즈한 부분이 덜 넘어갈 거 같습니다.

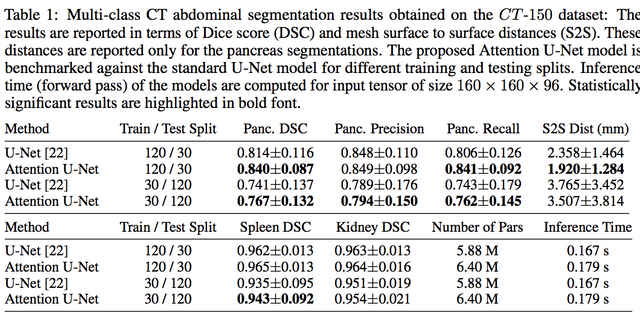

결과를 보시면.. UNet보다 성능이 좋네요. 시간이야 좀 더 걸리고...

논문의 아이디어는 단순하나, 어? 해 보면 재밋겠는데? 하는 결과입니다. 그리고 저자 그룹이 요즘 Medical image에서 재밋는 연구를 마구 쏟아내는 그룹이라 관심이 가는 논문이였습니다.

논문 소개 감사합니다.

#kr 태그를 달지 않으시면 한국어 사용자에게 글이 거의 노출되지 않습니다. @easysteemit 계정을 확인하시면 앞으로의 스팀잇 활동에 도움이 되실 것 같습니다.

그닥... 노출시킬만한 글도 아니고, 그럴 이유도 없는거 같아요. 그냥 페북 TensorFlow KR 분들에 쓸 때 그림 붙여넣기가 힘들어서 급조한 블로그라서요. 아무튼 감사합니다. 다음부터는 붙여볼게요.