AI学习笔记——线性回归(Linear Regression)

上一篇文章开始正式介绍机器学习的算法,在经典的监督学习算法中除了朴素贝叶斯算法还有那些其他经典的算法呢?

线性回归(Linear Regression)

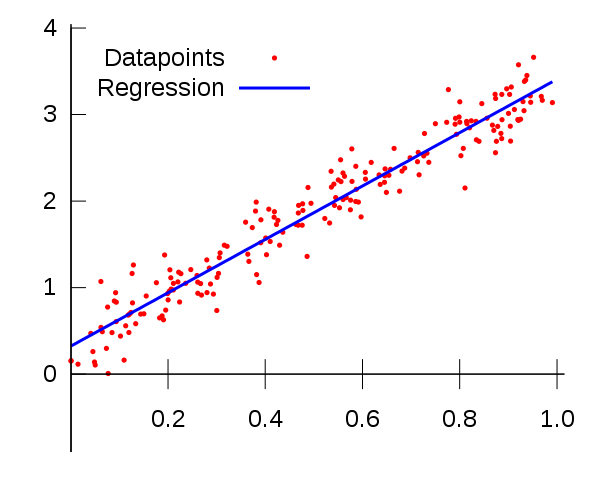

这是一个非常经典而简单的算法,就是用一条直线 y= w1*x + w0来拟合坐标上的数据,然后根据这条直线就可以根据x预测y。那实际上就是要找出合适的参数w1和w0。w1和w0两者的物理意义其实就是斜率和直线在x轴上的截距,当然其实这个并不重要。

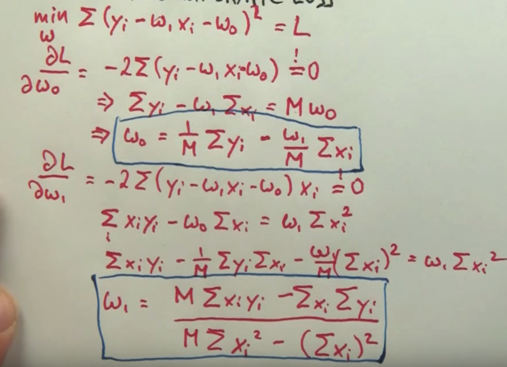

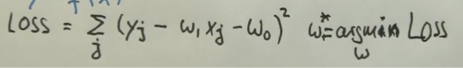

具体是怎么操作的呢,首先随机给出一个 w1和w0,然后我们需要评价这两个 w1和w0参数是否合适(与正确值的差距)。还记得在人工智能学习笔记二 —— 定义问题中提到的评价标准吗?这里的评价标准就是计算损失函数(Loss function):

其中,xi和yi即标记的样本点。损失函数在这里可以理解为所有预测值和实际值的差的总和。

如何让这个差值最小呢?这就用到了求导算极值了

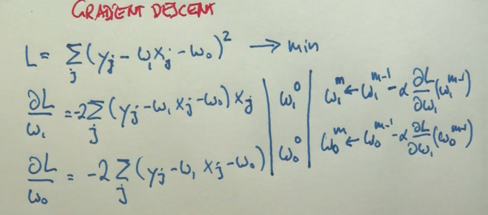

虽然从数学上 w1和w0两个值是可以求得的,但是实际上计算器是一步一步逐渐逼近这个结果的,这里需要用到梯度下降法(Gradient Descent)

这个概念非常重要,今后提到的深度学习和神经网络算法的优化理论基础就是这个梯度下降法。

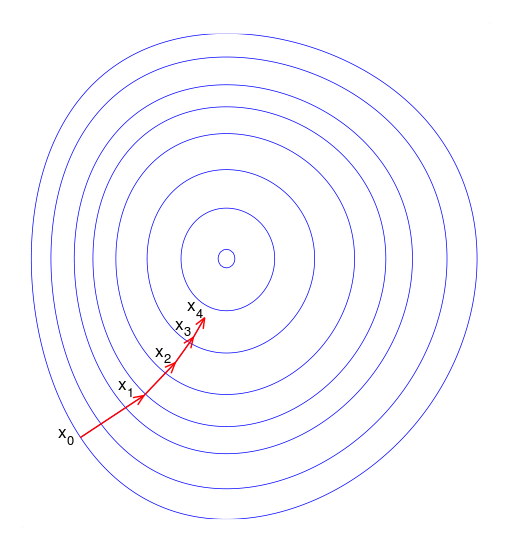

可以将损失函数想象成一个碗,通过上面的公式就是一步一步地改变w1和w0的数值,使损失函数最终达到最小(跌倒碗底)

相关文章

AI 学习笔记之——监督学习一朴素贝叶斯(Supervised Learning)

人工智能学习笔记之——人工智能基本概念和词汇

人工智能学习笔记二 —— 定义问题

Thanks for reading my posts and welcome to comment. If you like my post , please upvote , resteem and follow me @hongtao

感谢您的阅读,欢迎留言,如果您喜欢我的帖子,请帮忙点赞、推送及关注我 @hongtao